Jak z vlastní fotky vygenerovat video

23.10.2025Vaše statické fotografie ožijí v dynamických videích! Naučíme vás techniky rozpohybování vlastních obrázků s různými AI modely a tipy pro perfektní výsledky.

Přeměňte běžné fotografie na poutavá videa pomocí umělé inteligence v Everbotu. Ukážeme vám, jak správně promptovat, který model vybrat pro konkrétní scénáře a jak překonat běžné překážky při generování pohyblivého obsahu z vašich vlastních snímků.

Naučíme vás pracovat se složitějšími scénami, efektivně segmentovat prompty a kombinovat více vygenerovaných videí do perfektního celku. Dozvíte se praktické tipy pro práci s Google VEO 3, Kling a dalšími modely, včetně postupů pro postprodukci a úpravu výsledných videí v aplikacích jako CapCut.

Kompletní přepis webináře:

Krásný den, já jsem Honza z Everbotu a dnes se společně podíváme, jak z vašich vlastních fotek generovat videa. To je v Everbotu velmi jednoduché a předpokládám, že už jste to všichni zvládli, ale i tak se podíváme na nějaké tipy, jak s těmi videi pracovat a jak o tom přemýšlet, aby ty výstupy byly pro vás takové, jak je potřebujete.

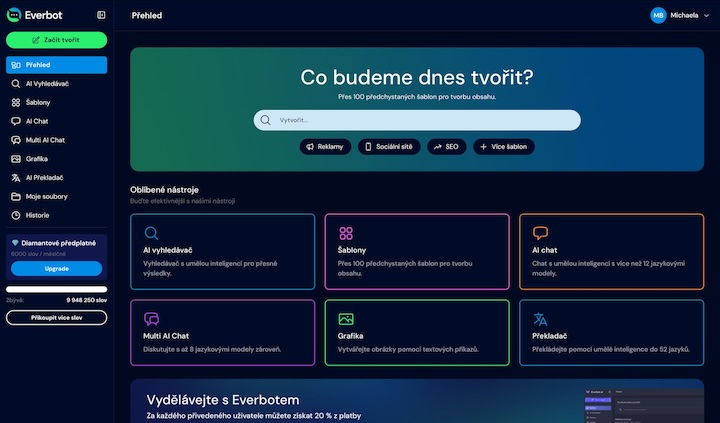

Pojďme se přesunout do Everbotu. Tady jsme v sekci AI video. Pokud se nepletu, tak téměř u všech modelů, nebo možná úplně u všech modelů, můžete přiložit nějaký vlastní obrázek. Za mě osobně takové doporučení, a uvidíte to i dnes na těch výsledcích, tak rozhodně mezi špičkou v tom generování patří Google VEO 3. Nicméně i tak, abyste vlastně dosahovali dobrých výsledků, tak nějakým způsobem musíte vědět, jak promptovat.

Já jsem si tady připravil několik příkladů a pojďme si je společně rozebrat. První příklad, který jsem tady měl, tak tohle je moje skutečné štěně, které jsem vkládal tady do obrázku a hrál jsem si s několika modely. Všechny ty nezajímavé výsledky jsem promazal a nechal jsem tady jenom to, co nás zajímá. První věc, která je na tomhle videu zajímavá, takhle tady si to zobrazím, tak je, že já jsem chtěl vlastně udělat, aby ten pes panáčkoval. Vlastně žádný z těch modelů mi nebyl schopný to splnit, což se vám jako velmi často může stát, že budete do toho textu zadávat něco a ono to prostě nebude plnit. Problém je ten, že tady ty věci jako panáčkování psa a cokoliv podobného, tak se velmi blbě vlastně překládá do angličtiny a ty modely vlastně přesto, že vy zadáváte česky, tak oni jako uvažují a myslí v angličtině. A tím pádem by byl mnohem lepší výsledek, kdybych zadal, že pes stojí na zadních a třeba předníma packama prosí nebo cokoliv podobného. Tak jenom když vlastně vidíte, že přesto vždycky říkáme, držte to zadání co nejvíce jednoduché, tak když zadáte něco, čemu prostě ten model nerozumí, tak to nedopadne dobře.

Další, pojďme si ukázat další video, které jsem udělal z Google VEO 3 a mám tady několik výsledků, já si vypnu zvuk. Tak několik výsledků tak je, že jsem chtěl, aby ten pes chytil tenisový míček. U všech těch modelů dneska, zvláště když jde o právě nějaké pohyby, že se někdy nějak velmi prudce pohybuje, typicky u těch sportů, když generujeme cokoliv podobného, tak všechny ty modely mají nějaký problém, řekněme to dát tak, aby to mechanicky a fyzikálně fungovalo správně. To znamená, že pokud bychom chtěli vygenerovat video psa, jak chytá míček, tak nejlepší výsledek byl Google přes VEO 3 Quality a zároveň ale vidíte, že to má, jak se říká, mouchy.

Takže já jsem tam nahrál svoji vlastní fotku, skutečnou fotku a chtěl jsem, aby ten pes chytil tenisák. Tak jak bych postupoval ve skutečnosti, kdybych to potřeboval dotáhnout do zdárného konce, tak bych si těch videí vygeneroval několik. Stejné zadání, stejná fotka. Vygeneroval bych těch videí třeba pět nebo šest a vlastně bych si to v aplikaci CapCut dostříhal do nějakých rámců. Musel bych být spokojený s tím, že nemám úplně plynulé video, ale dostříhal bych to tak, že třeba ten tenisák někde letí k tomu psovi, potom že ho ten pes třeba nějak vyskočí a pak další střih, že ho má třeba v tlamě. Běžně to takhle děláme do reklam, které generujeme, když jsou nějaké náročné ty pohyby nebo cokoliv podobného, tak je to tenhle postup.

Další věc, kterou vám chci ukázat a kterou často řešíte, tak tady jsem si nechal ještě jedno z těch videí omylem, tak je generování, že máte nějaký produkt, jak ukážu, jsem měl tady takovéhle holínky, máte nějaký produkt a ten produkt chcete rozpohybovat. Je dobré zase popsat tu scénu co nejvíc, já se podívám tady, jsem opět v Google VEO 3 Quality, jsem dal, že muž nasazuje holínky. Vlastně vidíme, že ten výsledek není vůbec špatný, ale jsou tam nějaké pohyby, které jsou nevysvětlitelné, tady to upravování těch lemů a cokoliv podobného. Zase nějaká fyzikální věc, se kterou ty modely ještě dneska prostě neumí úplně uvažovat. To znamená, že je potřeba z těch videí zase nagenerovat více a v podstatě třeba tady od toho momentu, kdy je to perfektně nasazené, ještě tak jako jedna noha více taková, druhá maková, tak si to vlastně můžeme dostřihnout až do nějakého momentu, kdy ten muž už třeba odchází z toho záběru.

Zároveň, když to nasadíme takhle jako jednoduše, že napíšeme muž nasazuje holínky, tak vlastně nevíme, do jakého toho prostředí nás to zavede. Když tady ale dáme, že muž nasazuje holínky na stavbě, tak vidíme, že už jsme na nějaké stavbě, už někde něco potřebujeme. Problém je zase ten, že zase tady bylo nějaké zase upravování té holínky takové zvláštní, které by vlastně ten náš divák nepochopil. Takže zase opět se dostáváme k tomu, že vidíme, že tady od té části už je to super přibližně a zbytek bude nějakým způsobem potřeba dostříhat. To znamená... že bych si zase to video vygeneroval třeba třikrát, čtyřikrát za sebou a různě bych ho postříhal tak, jak bych potřeboval, aby mi vycházelo, anebo bych se prostě vlastně musel spokojit s tou částí, kde už to je v pořádku, anebo opět vygenerovat víc pokusů a čekat, který ten pokus bude ten správný.

Tak, další věc, co vám chci ukázat, tak je zase nějaká jednoduchost toho promptu. Já jsem si tady vygeneroval fotku nějakého hradu ve Skotsku a chci si vygenerovat několik scén. Jednak jsem generoval muže, co venčí psa, potom muže a psa, co dává pac a muže, který odpaluje golfový míček. Pojďme si okomentovat jednotlivé výsledky, jak s tím pracovat.

Když si zadáme tu fotku a necháme na té umělé inteligenci, na tom modelu, tak nějakým způsobem něco udělá, tak ten výsledek je vždycky nejlepší, co se týče kvality toho obrazu, ale zároveň může být nejhorší z pohledu toho, jak jste si tu scénu představovali vy a jak je ten výsledek. Co se týče toho obrázku na začátku, tak často bývá potřeba si to v nějakém CapCutu nebo v DaVinci nebo v něčem ostřihnout, ale vlastně vidíte, že když jsem zadal, že muž venčí psa a nedával jsem tam jaký to je plemeno a že ten pes panáčkuje cokoliv podobného, tak ten výsledek je jako prostě v pohodě, je to zase z jednoho prostředí toho hradu, cokoliv podobného. Je tady rizikové, když si tam třeba budete dávat skutečnou nemovitost a budete chtít třeba se jako provést kolem té nemovitosti, tak ta umělá inteligence si domyslí, jak ta nemovitost vypadá z více úhlů nebo to jako jenom stylizuje do té krajiny a do té nemovitosti, ale nebude to úplně jako přesně odpovídat realitě. Takže vidíme, že s jednoduchým promptem si to poradí úplně v pohodě. Když ale jsem tam zase zadal něco jako, že pes dává muži pac, což je zase komplikované, tak ta umělá inteligence to asi nepochopila ani na víc pokusů. To znamená, že zase potřeba si prostě říct, promptovat to tím způsobem, že muž klečí před psem a pes podává přední nohu do ruky muže nebo něco takového. Prostě dávat ty prompty ne jako česky slangově, ale dávat je tak, jak mají být, jinak vlastně ty výsledky budou takové.

Tak a potom další, tady máme golfový odpal. Zase je to komplikovaný sport, jak jsem prostě říkal, sportovní věci, jakékoliv jako střelby a běhy a skoky a různé jako posouvání rychlých předmětů a podobně, tak je komplikované. A zároveň ten model třeba úplně nechápe, že třeba odpalovat proti zdi nedává úplně smysl. Nicméně, když potřebujete golfovat, když potřebujete, pardon, když potřebujete generovat tady ty, řekněme, složité věci, tak vždycky na to nejlíp, a ukážu vám výsledky, funguje Google VEO 3. Nicméně i tak, když se vám nedaří v jednom modelu, tak prostě zainvestujte čas, dejte si ten stejný příkaz do všech těch ostatních modelů, protože je prostě možné, že některý model vám to zadání zpracuje líp.

Nicméně já už dneska chodím na jistotu a cokoliv potřebuji rozpohybovat z vlastních fotek, tak to téměř vždycky dělám přes Google VEO Quality. Takže vidíme, že tohle je jako nejlepší výsledek, jaký tam nějakým způsobem dopadl. Nicméně pokud bychom to zase chtěli udělat reálně, tak by bylo fajn si to vlastně rozkouskovat, že bychom chtěli toho muže, jak zapichuje týčko, toho muže, jak se připravuje na odpal a podobně zadat si to takhle v jednotlivých větách a potom si to nějakým způsobem pospojovat. Takhle, jak je ta scéna moc dlouhá, moc dynamická, tak to je pro tu umělou inteligenci ještě pořád dneska složité. Nicméně, když jsem říkal, pojďme si to vyzkoušet v dalších modelech, abyste viděli, co se stane, tak stejný příkaz v Klingu 2.5 vypadá docela dobře, ale právě stalo se třeba to, že ten muž vůbec nestojí na nádvoří toho hradu, ale najednou je tady nějaký green kombinovaný s odpalištěm a v podstatě ten muž tady odpaluje vlastně, byť výsledek je docela fajn, ale třeba takhle jsem to vůbec nemyslel. Ale Kling 2.5 umí vlastně ty scény i ty pohybové perfektně, takže pak je tady na vás, prostě si vygenerovat těch věcí více, jestli se náhodou na další pokus netrefí.

Když bychom řekli, že se nám z Klingu 2.5 nelíbilo, tak říkáme, zkusíme další model, tak vidíme, že třeba Kling 2.0 vlastně vůbec nepochopil to zadání a nebyl schopný to zpracovat. Kling 1.6, tak to udělal jako jeho ninju zvláštního a to se prostě jako běžně stane, že vy si dáte právě ten příkaz a ten model to právě zpracuje třeba takhle nějak divně, tak vyzkoušejte znovu generovat a pokud se ten výsledek opakuje, tak vyzkoušejte jiný model. Za mě právě nejčastěji, když potřebujete rozpohybovat tu vlastní fotku, tak Google VEO 3 vám to rozpohybuje snáze. Když byste od toho Klingu zadali, že muž jako odpaluje, tak je to mnohem snazší pro to vyřešení, než když ho máte zasadit do toho vlastního prostředí.

No a potom tady máme Wanx 2.1, který v podstatě to udělal hezky, ale nepochopil tu scénu. Takže zase by bylo potřeba možná nejdřív říct, muž stojí s golfovou holí na nádvoří hradu, připravuje týčko, zapichuje ho do trávy a podobně to nějakým způsobem rozčlenit nebo nějakým způsobem rozpohybovat. Zároveň, když třeba máte takovouhle, řekněme, jako scénu, kde je to složitější a můžete si ji vygenerovat přes generátor obrázku, tak si nejdříve nagenerujte obrázky a potom rozpohybávejte ty jednotlivé obrázky, protože díky práci se seedem se vám podaří udělat sérii, která je sobě velmi podobná, vy jste následně schopni přegenerovat video.

Co říct závěrem? Jsme u konce toho dnešního tipu a chci tím vlastně říct několik věcí. Pokud se vám nedaří práce v jednom modelu, zkuste ji v modelu druhém. Pokud potřebujete rozpohybovat vlastní fotku a ten výsledek se vám nelíbí, tak zkuste zjednodušit ten prompt anebo ten prompt, jak se říká, rozřezat na menší části, ať prostě nepromptujete takovou velkou činnost, ale prostě tam dáte třeba muž má na nohách holínky, muž v holínkách dělá tři kroky, cokoliv podobného a zkusit to takhle, jak se říká, rozkrájet. Bohužel ta inteligence ještě není dneska tak daleko, žádný z těch modelů není tak daleko, aby nám to vygenerovalo dvou-tří minutovou reklamu bez nutnosti zásahu jakéhokoliv CapCutu nebo nějaké následné editace. Pokud neumíte editovat, tak mrkněte na záznamy z našich dílen a ve vzdělávání. Jsou tam videa, kde se CapCutem zabýváme, nebo přijďte na naši dílnu a tam si můžeme ukázat, jak s tím CapCutem pracovat a jak to ostříhat. Jsme u konce dnešního tipu a já doufám, že vám pomohl dát nadhled, jak ty modely přemýšlí, jak s nimi pracovat, aby ty vaše výsledky byly lepší, protože ve chvíli, kdy pochopíte to myšlení, tak najednou ty výsledky začnete dostávat tak, že se nebudete rozčilovat nad tím, že jsou špatné, ale budete prostě chápat, že si toho máte nagenerovat víc, případně nějakým způsobem dostříhat a cokoliv podobného.

Já doufám, že vám tohle ušetří spoustu práce, času a nervů v budoucnosti při generování videí, že vás to posune v té tvorbě dál. Pokud byste měli jakékoliv dotazy, tak můžete nám napsat na info@everbot.cz a naši kolegové vám moc rádi odpoví a odpovídají tak nejlíp, jak to budou umět. A nebo je tady další možnost. Každou středu v 10 hodin můžete dorazit na naše AI dílny, což jsou takové živé online rozhovory se mnou a s dalšími kolegy a nebo s dalšími odborníky na různé věci jako mailing, SEO a cokoliv podobného. A vždycky tam s vámi řešíme jednak vaše všechny dotazy a zároveň vždycky vám ukazujeme nějaké odborné téma, jak umělou inteligenci používat pro vaše podnikání. Tak dorazte s vašimi dotazy, moc rádi se vám budeme věnovat a rádi vám pomůžeme umělou inteligenci používat tak, aby ty výsledky byly co nejvíce podle vašich představ.

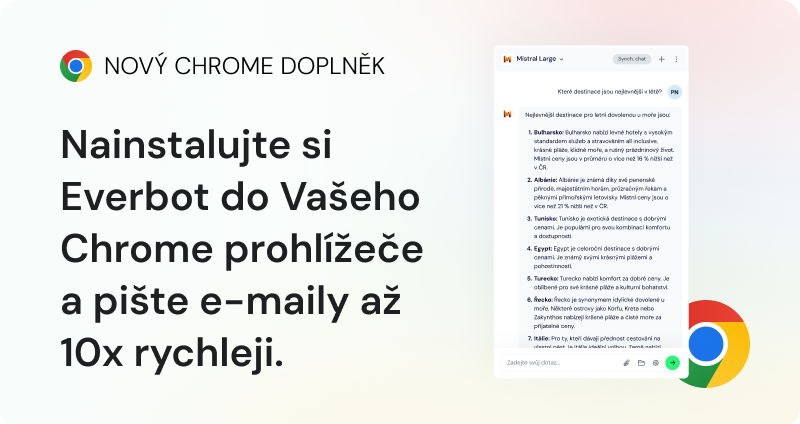

Pokud jste tohle video viděli a Everbot ještě náhodou nemáte, tak klepněte na odkaz pod tímto videem a zaregistrujte si jeho pětidenní bezplatnou verzi a Everbot si ošahejte, začněte s umělou inteligencí konečně pracovat a pracujte s Everbotem. Protože Everbot má ambici stát se světovou jedničkou a já si nemyslím, že by to bylo nějaké klišé nebo nějaký, řekněme, marketingový claim. Naši vývojáři tvoří Everbot tak, abyste výsledky dostávali ideálně na jedno až dvě kliknutí, nemuseli nějak složitě promptovat a vše měli pod jednou střechou a tím šetřili nejenom čas, ale taky peníze za různá předplatná a cokoliv podobného. Tak zkuste Everbot a věříme, že začnete umělou inteligenci používat, jak se říká, na plný výkon. To je dnes ode mě vše a já se s vámi těším na viděnou u dalšího Everbotího videa.

Vyzkoušejte aplikaci Everbot bez závazků a bez rizika

Ušetřete až 6+ hodin denně a tvořte obsah, který prodává, s Everbotem na pár kliknutí.